Der kommer flere og flere eksempler på AI-modeller, der er trænet på AI-genereret data – bedre kendt som syntetiske data. Disse kan f.eks. bruges til at berige mindre datasæt med flere data, eller de kan simulere sikkerhedsfølsomme data, så man minimerer risikoen for dataudslip. Det lyder jo meget smart, men syntetiske data kommer ikke uden udfordringer.

Elon Musk var for nyligt ude at proklamere, at verden er løbet tør for menneskeskabte data til at træne AI-modeller på. Og selvom Musk er kontroversiel, så har han ret i, at det er en udvikling, der har været undervejs i noget tid. De store AI-modeller bruger ganske enkelt mere data, end menneskeheden kan nå at generere.

Det betyder, at de store AI-virksomheder i flere tilfælde er begyndt at træne sine modeller med syntetiske data – altså data genereret af AI ud fra de organiske data, de har til rådighed. Det kunne for eksempel være tekster fra ChatGPT eller billeder fra DALL-E.

Den udvikling betyder, at AI-modellerne risikerer at blive dummere og mindre præcise, fordi træningen bliver mere generisk, ensformig, eller ja, syntetisk. I værste fald kan man ende med et model collapse, hvor modellernes svar ganske enkelt bliver ubrugelige, fordi der er for mange hallucinationer eller faktuelt forkerte informationer i de data, som modellerne er trænet på – og som altså repliceres i de syntetiske data.

Men hvorfor gør tech-virksomhederne det så? Det skyldes, at der også er eksempler på, at nogle AI-modeller faktisk bliver bedre, når de trænes på syntetiske data – hvis disse data da er lavet omhyggeligt.

Så lad os se nærmere på, hvornår det giver mening at bruge syntetiske data, og hvad man skal være opmærksom på, hvis man kaster sig ud i et syntetisk eventyr.

Organiske data vs. syntetiske data

Kvalitet er alfa og omega, når vi snakker data. Hvis inputtet er dårligt, så er outputtet det også, og det gælder i særdeleshed også for AI-modellerne, som jo grundlæggende er store data-systemer.

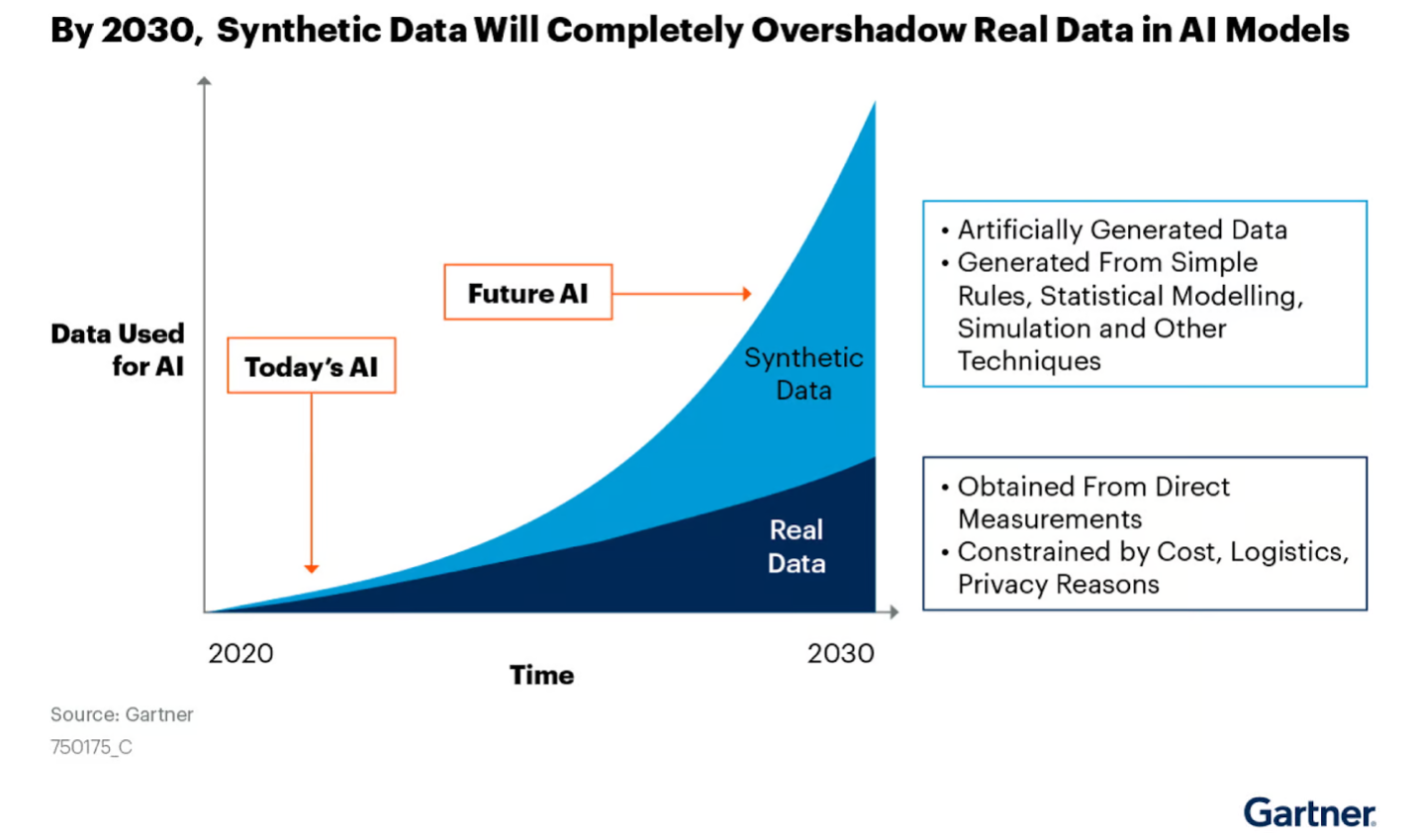

Indtil videre er langt de fleste AI-modeller trænet på organiske data – altså ”almindelige” menneskeskabte data som tekst, tal, billeder og videoer. Men hvis man skal tro Gartner, så vil vi se en eksponentiel stigning i anvendelsen af syntetiske data til AI-træning frem mod 2030:

Denne forudsagte udvikling skyldes blandt andet, at de organiske data kommer med en del menneskelige problemer. Faktisk er det både deres styrke og deres svaghed.

For selvom de organiske data er mere ”ægte” – i og med at de er virkelighedstro og typisk mere nuancerede end syntetiske data – så er de også fejlbefængte. Der kan både være strukturelle problemer som stavefejl og irrelevant indhold, men der kan også være problemer med menneskelig bias. Det er for eksempel sådan man ender med AI-modeller, der har svært ved at generere billeder af kvindelige chefer, homoseksuelle par, eller på anden måde udviser en form for bias i sine svar. Et problem som er blevet pointeret for næsten alle de større modeller som ChatGPT og Grok-2.

Derudover tager organiske data lang tid at udarbejde og strukturere på en måde, der giver mening for AI-modellerne. Og som vi skrev indledningsvist er der altså også en mangel på organiske data til at træne modellerne op.

Det problem vil man ikke støde på med syntetiske data. For eftersom de genereres af AI selv, er der en uendelig kilde til nye data. Syntetiske data kan desuden genereres mere struktureret og indeholder færre fejl end menneskelige datasæt. Samtidigt kan de potentielt være mindre biased, end de organiske data – men det kræver, at man er meget opmærksom på biases i de organiske data, som de syntetiske data skal replicere. Ellers ender man blot med at forstærke de samme biases gennem de syntetiske data, og så har vi balladen.

Hvornår giver det mening at anvende syntetiske data?

Ligesom med de organiske data kommer de syntetiske data altså heller ikke uden udfordringer, og det er vigtigt at være opmærksom på kvaliteten af de syntetiske data, inden man giver sig i kast med at træne sine AI-modeller på dem.

Der er dog også en del gode grunde til at anvende syntetiske data. Som vi ser det, er de tre primære brugsscenarier:

- Små datamængder

Hvis man som virksomhed har meget få data, eller hvis dine data er ujævnt fordelt (for eksempel langt flere eksempler af én bestemt kundetype end en anden), kan syntetiske data være en vej til et større og mere balanceret datasæt. Det kan hjælpe med at undgå, at en model bliver skæv i sine forudsigelser. - Data Privacy

Det er ofte udfordrende at bruge kundedata direkte i modeller, fordi personfølsomme oplysninger kan være svære at anonymisere. Syntetiske data ligner de rigtige data på de træk, der er vigtige for AI’en, men gemmer individers identitet væk. Dermed kan man træne en model uden at dele eller bruge reelle kundedata. - Forbedret AI-performance

I nogle tilfælde kan syntetiske data hæve kvaliteten af en models svar. Små eller mellemstore modeller kan “lære” fra data genereret af større, mere avancerede modeller. Det er en slags “student-teacher”-tilgang, hvor den mindre model får en skræddersyet undervisning af en mere avanceret “lærer.” Resultatet kan være bedre performance til en lavere omkostning end at bygge alt fra bunden.

Udfordringerne ved syntetiske data

Som vi lige fik teaset lidt for, så skal man ikke bare kaste sig hovedkulds ud i at producere og anvende syntetiske data. I værste fald kan man ende med at degenerere sine AI-modeller, så deres svar bliver for simple og mangler de nuancer og kontekster, som organiske data typisk afspejler bedre. Man ender altså i en spiral, hvor AI-modellen gentager sine mønstre og gradvist bliver dårligere for til sidst at ende i et model collapse.

Desuden replicerer syntetiske data jo de organiske data, så hvis der er mange fejl i disse data, risikerer man at de syntetiske data genskaber fejlene, så de i sidste ende kommer med i svarene. Det kan resultere i hallucinationer og faktuelt forkerte svar fra modellerne. Der vil vi helst ikke hen.

Derfor er det vigtigt at huske på, at mere data ikke nødvendigvis er bedre data. Kvaliteten er derfor stadig det afgørende, og det er vigtigt at sikre kvalitetsniveauet i både organiske og syntetiske data. Den gode gamle devise om ’kvalitet over kvantitet’ bør således være dit mantra i denne sammenhæng.

Syntetiske data er dermed ikke en nem genvej, der løser alt. De kan supplere og styrke eksisterende datasæt, mindske risikoen for datalæk og sikre, at modeller trænes på et mere balanceret grundlag. De kan også spare tid og beskytte privatliv, når man ikke vil arbejde direkte med personfølsomme oplysninger.

Men gevinsten afhænger af, om man har styr på sin “originale” datakilde og forstår, hvordan man genererer syntetiske data korrekt. Går man til opgaven med de rette værktøjer og en solid strategi, kan man slippe for nogle af de faldgruber, der opstår, når man blindt accepterer syntetiske data som løsningen på alt.

Det kan være en fin medspiller, men det erstatter ikke behovet for nuanceret, menneskeskabt data, som ofte rummer de vigtigste sandheder og den største dybde. Kombinerer man det bedste fra begge verdener, er der gode chancer for at stå stærkere på både kort og lang sigt.